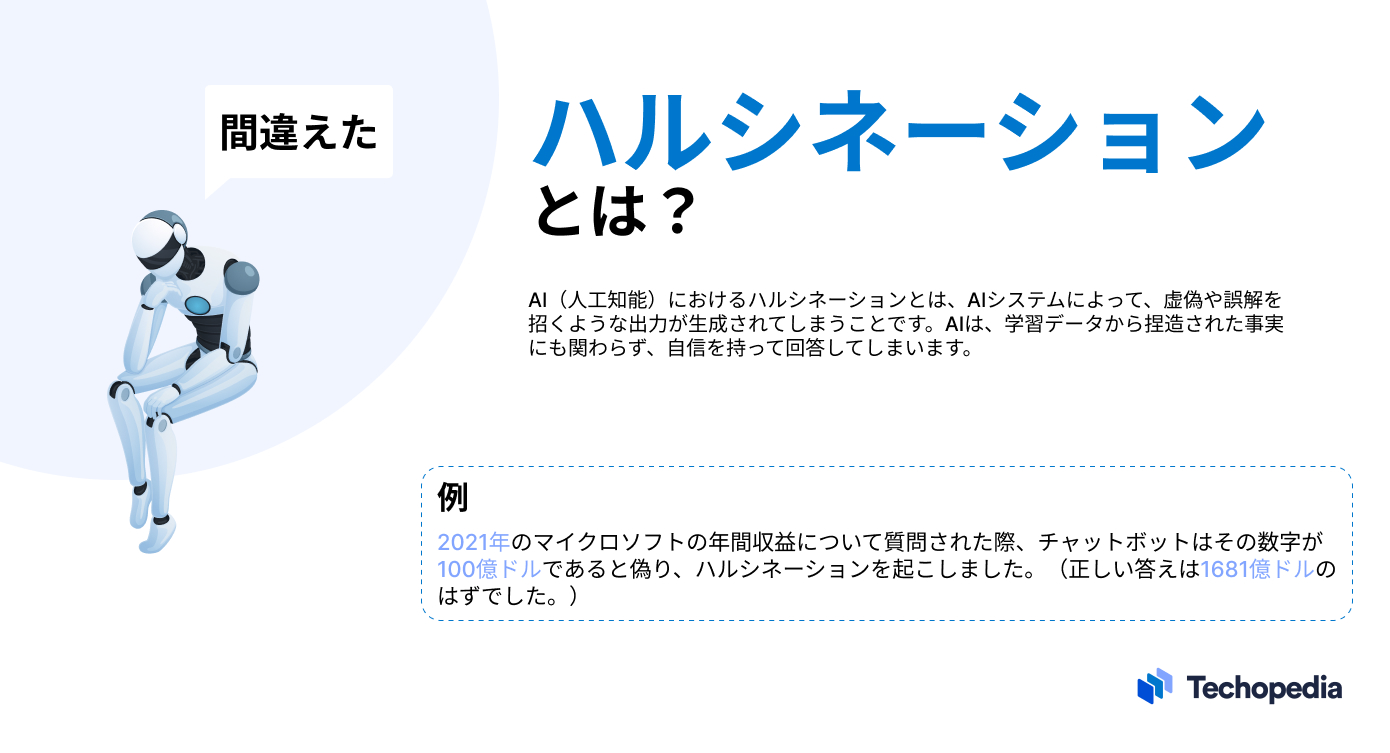

人工知能(AI)におけるハルシネーションとは

人工知能(AI)におけるハルシネーションとは、OpenAIのGPT-4やGoogle PaLMのような大規模言語モデル(LLM)が、実際のデータや出来事に基づかない虚偽の情報や事実を作り出すことを指します。

調査会社ガートナーのアナリストであるアビバ・リタン(Avivah Litan)は次のように説明しています。

ハルシネーションは、LLMから完全に捏造された出力のことです。完全に作り上げられた事実なのにもかかわらず、LLMはその出力を自信を持って権威あるものとして提示します。

生成AIによるチャットボットは、名前、日付、歴史的イベントから引用句やコードに至るまで、あらゆる事実情報を捏造することができます。

ハルシネーションはよくあることで、OpenAIはChatGPT内でユーザーに対して「ChatGPTは人物、場所、または事実について不正確な情報を生成する可能性があります」と警告しています。

ユーザー側の課題は、どの情報が真実で、何が真実でないかを見分けることです。

ハルシネーションが生じた事例

人工知能(AI)におけるハルシネーションの事例はたくさんありますが、最も注目すべき事例の一つは、2023年2月にGoogleが公開したプロモーション動画です。その動画の一部では、AIチャットボットのBardが、ジェイムズ・ウェッブ宇宙望遠鏡が太陽系外の惑星を初めて撮影したと誤って主張しました。

同様に、2023年2月のマイクロソフトのBing AIのローンチデモでは、BingがGapの収益報告書を分析し、事実や数字が誤った要約を提供してしまいました。

上記の例は、ユーザー側がチャットボットから常に真実の回答を得られると信じ込んではいけないことを表しています。しかし、ハルシネーションによる危険性は、誤情報の拡散だけにとどまりません。

実際、Vulcan Cyberの研究チームによると、ChatGPTは存在しないURL、参照、コードライブラリを生成したり、ユーザーに悪意のあるソフトウェアパッケージを推奨したりすることさえできてしまいます。

LLMや生成AIの実験を行う組織やユーザーは、こういった技術やツールを使用する際には十分な注意を払い、出力の正確性をダブルチェックする必要があります。

ハルシネーションの原因

人工知能(AI)におけるハルシネーションを生じさせる主な要因は以下の通りです。

- 情報が古いまたは低品質の学習

- 分類やラベリングが不適切なデータ

- 学習データの事実誤認、矛盾、バイアス

- 情報を正しく解釈するためのプログラミング不足

- ユーザーによって提供された文脈や意図の欠如

- 口語表現、俗語表現、または皮肉の意図を推測する困難さ

できるだけ詳細に平易な言葉でプロンプトを書くことが重要です。ハルシネーションの可能性を軽減するために十分なプログラミングと予防策を実装することは、最終的には企業側の責任になります。

ハルシネーションの危険性

ハルシネーションの主な危険性は、ユーザーがAIシステムの出力の精度に過度に期待することです。

マイクロソフトのCEOであるサティア・ナデラのように、マイクロソフトのCopilotのようなAIシステムが「有益な間違い」をするかもしれないと主張する人がいますが、これらのモデルやツールがチェックされずに放置されると、誤情報や悪意に満ちたコンテンツが拡散される可能性が高まってしまいます。

LLMが生成する誤情報への対処は困難です。なぜなら、サービス上では詳細で説得力があり、信頼できるように見えるコンテンツを生成できるためです。しかし、実際にはその内容は不正確である場合、ユーザーが不正確な事実や情報を信じ込んでしまいます。

また、ユーザーがAIが生成したコンテンツをそのまま受け入れてしまう場合、インターネット全体に誤った情報が拡散される可能性があります。

最後に、法的責任およびコンプライアンス責任のリスクも存在します。例えば、組織がLLM駆動のサービスを利用し、ユーザーの財産を損なうような指導を出したり、攻撃的なコンテンツを繰り返し生成する場合、法的措置のリスクにさらされる可能性があります。

ハルシネーションの検出方法

AIシステムがハルシネーションを起こしているかどうかを検出する最善の方法は、モデルやサービスから提供された出力を手動で第三者ソースによる事実確認をすることです。出力された事実、数字、議論の内容を、ニュースサイト、業界レポート、論文、書籍、そして検索エンジンでチェックすることで、情報が正確かどうかを検証することができます。

手動でチェックすることは、誤情報を検出したいユーザーにとっては良い選択肢ですが、企業側にとって情報の各セグメントを検証することは、物理的にも経済的にも現実的ではないかもしれません。

企業は、生成AIのハルシネーションをダブルチェックするために自動ツールの導入を検討すると良いでしょう。例えば、Nvidiaのオープンソースツール「NeMo Guardrails」は、あるLLMの出力を別のLLMと照合することでハルシネーションを識別することができます。

同様に、Got It AIの「TruthChecker」を使えば、GPT-3.5+で生成されたコンテンツのハルシネーションをAIで検出することができます。

もちろん、Nemo GuardrailsやGot It AIのような自動ツールを使用してAIシステムのファクトチェックを行う組織は、これらのサービスが誤情報を特定する効果をどの程度持っているかを検証し、潜在的な責任を排除するために取るべき措置が他にあるかどうかを判断するリスク評価を実施したりなど、十分な注意を払う必要があります。

まとめ:ハルシネーションと今後の対策

AIとLLMは企業にとって非常に魅力的な能力を持っていますが、正しい結果を得るためにも、ハルシネーションをはじめとする技術のリスクと限界に留意することが重要です。

最終的に、AIサービスが最も価値を発揮するのは、人間の知能を置き換える試みではなく、人間の知能の補完に使用したときです。

ユーザーや企業がLLMが情報を捏造する可能性を認識し、出力データを別の手段で検証していけば、誤情報を拡散・吸収するリスクは最小限に抑えられます。